售前咨询

快手万擎(Vanchin)

模型精调

更新时间:2026-01-22 15:59:39

若模型表现不能满足您的需要,您可以使用模型精调能力,通过SFT、DPO的方式对模型参数进行优化,使其更加适配业务场景。

体验链接:模型精调

判断精调必要性

精调限制

- 难以通过精调实现模型通用基础能力,如推理能力优化、长上下文理解等能力的大幅提升;

- 难以通过精调提高模型对高时效性信息的检索能力,建议您使用Function Call调用支持联网搜索的插件;

- 难以通过精调提高模型对特定领域信息的检索能力,建议您使用知识库能力。

精调成本

- 需高质量标注数据(如问答对、偏好排序),数据清洗和标注可能消耗大量人力;

- 超参数调优、验证集迭代可能需多次试验,耗时数天至数周。

新建精调任务

【⚠️当前仅支持文本生成类模型进行精调】

进入模型精调页面,点击「新建精调任务」,进入创建页面:

- 选择精调方式

- SFT(Supervised Fine-tuning):指采用预先训练好的神经网络模型,针对用户自己的专门任务在少量的监督数据上对其进行重新训练的技术。

- SFT的作用

- 任务适应:预训练模型往往是在大规模无标注或自监督数据上训练的,虽然具备了一定的通用能力,但可能并不完全适应特定任务。通过有监督精调,模型可以学习到特定任务的数据分布和模式,从而提升在该任务上的性能。

- 提升性能:精调能够进一步调整模型的参数,以优化在特定任务上的性能。

- 减少数据需求:相对于从头开始训练模型,有监督精调可以在预训练模型的基础上进行,因此通常能够更快地收敛,减少训练时间和训练成本。

- DPO(Direct Preference Optimization):训练数据集数据同时提供正负样本,通过引入负反馈,降低幻觉,对bad case进行针对性优化。

- DPO的作用

- 偏好对齐:DPO通过显式对比样本对,使模型学习人类的偏好模式,从而生成更符合预期的响应。

- 优化输出质量:在对话、摘要、文本生成等任务中,DPO通过强化模型对“高质量响应”的识别能力,减少冗余、矛盾或不相关的内容,提升输出的准确性和用户体验。

- 降低标注成本:相比传统强化学习需要构建复杂的奖励模型,DPO直接利用偏好数据对(如“用户更喜欢A而非B”)进行训练,简化流程并减少对额外标注资源的依赖。

- 选择精调模型,支持选择模型广场模型及用户自有模型;

- 选择训练方法

- 全量更新:指在预训练模型的基础上,对其全部可训练参数进行重新训练,使模型整体适配新的任务或数据分布。

- LoRA:一种参数高效精调方法,在固定预训练大模型本身参数的基础上,保留自注意力模块中原始权重矩阵,对权重矩阵进行低秩分解,训练过程中只更新低秩部分的参数。

- 参数配置:见下方表格。

- 选择数据集:可选择平台已发布数据集版本或内置数据集。

- 选择验证集:可从当前选择的数据集中随机拆分作为验证集,或选择指定数据集作为验证集。

- 选择发布方式

- 发布为新模型:此次训练的模型发布后使用新的模型名称。

- 已有模型新版本:同系列模型仅更新版本,不更新模型名称。需保持基础模型一致、精调方式一致、任务类型一致、训练方法一致。

- 计量计费:精调配置选择完毕后,页面将展示计费详情。预估条件(精调方式、基础模型、基础模型版本、训练方法、数据集、验证集)均填写后,将展示折合后的具体金额范围;若预估条件不充分,将提示“按token后付费”。

训练配置-参数说明:

查看微精调任务

当项目下存在精调任务时,用户可在模型精调页面查看该项目下的所有精调任务信息,点击某个任务名称将进入该任务详情,可查看任务的详情信息、效果指标、训练日志。

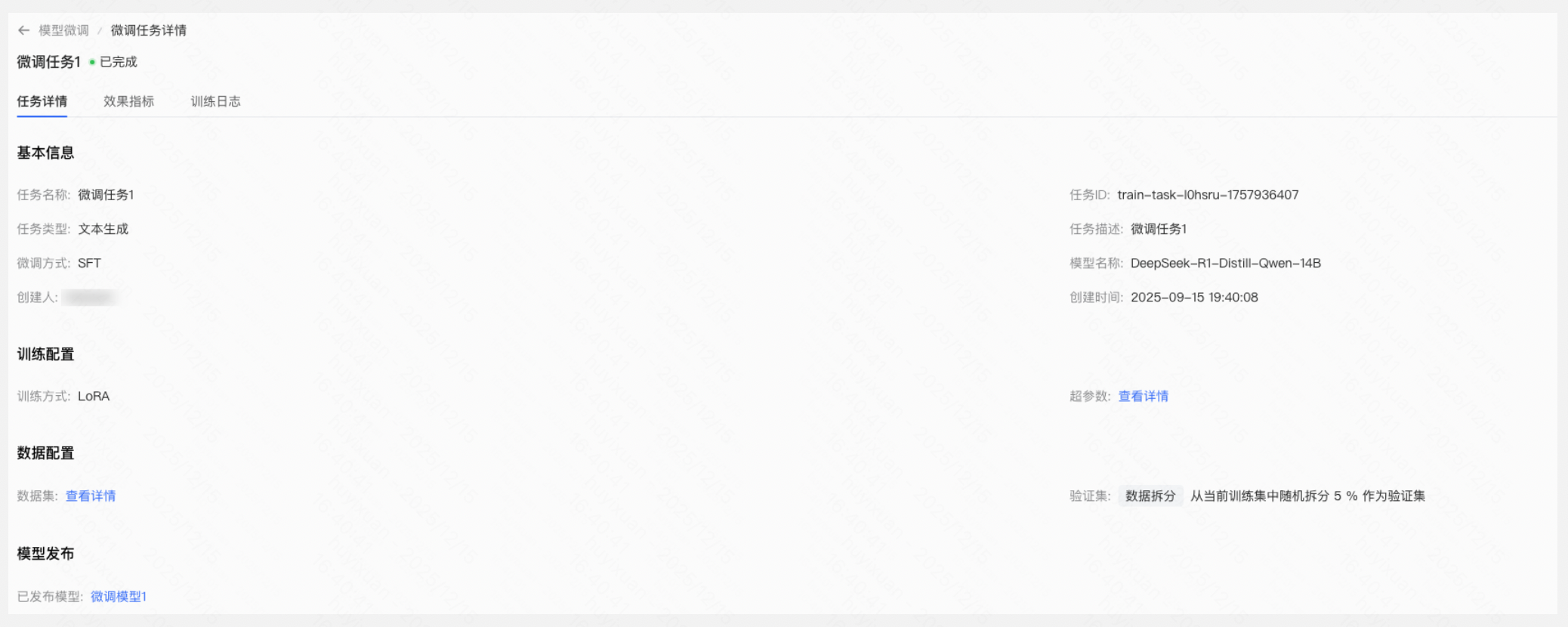

任务详情

任务详情页面展示该精调任务的以下信息:

- 剩余时间:若任务处于运行状态,将展示任务已持续时间及预估剩余时间。

- 训练配置:展示任务的训练方法及参数配置,点击「查看详情」将展示对应任务所配置的超参数。

- 数据配置:数据集展示数据集表格;验证集:若为数据拆分将展示数据拆分、拆分比例,选择数据集将展示数据集表格。

- 模型发布:已发布模型将展示已发布模型名称,点击将展示模型仓库中该模型详情。

效果指标

【⚠️若任务处于排队中状态 ,将无法查看效果指标】

基础指标

- loss:模型在数据集上计算得到的损失值,衡量模型对训练数据的拟合程度。

- eval_loss:模型在验证集上计算得到的损失值,模拟模型在未知数据上的表现。

- lr:学习率(Learning Rate),控制模型参数更新步长的速度。过高会导致模型难以收敛,过低则会导致模型收敛速度过慢。

DPO指标

- rewards accuracies:模型预测的偏好与标注一致(rewards chosen > rewards rejected)的频率。值越大效果越好。

- rewards margins:偏好选中和偏好拒绝奖励的平均差值(rewards/chosen - rewards/rejected)。值越大代表效果越好。

- rewards chosen:偏好选中(chosen)的回复奖励值,值越大代表效果越好。

- rewards rejected:偏好拒绝(rejected)的回复奖励值。值越小代表效果越好。

- logps chosen:选择偏好选中(chosen)的对数概率平均值。值越大效果越好。

- logps rejected:选择偏好拒绝(rejected)的对数概率平均值。值越小效果越好。

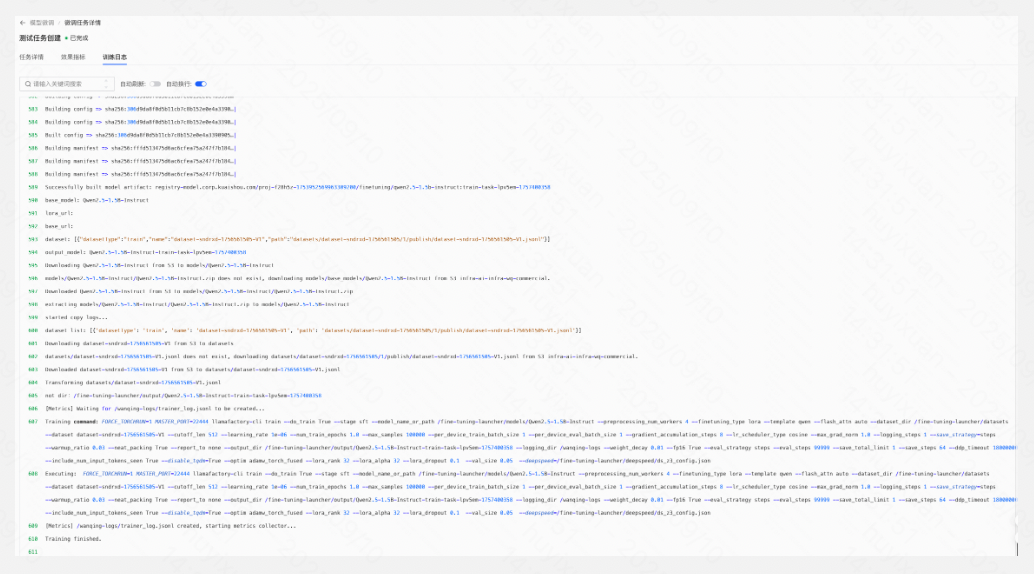

训练日志

【⚠️若任务处于排队中状态 ,将无法查看训练日志】

在训练日志页面,您可查看该精调任务的日志详情: